0

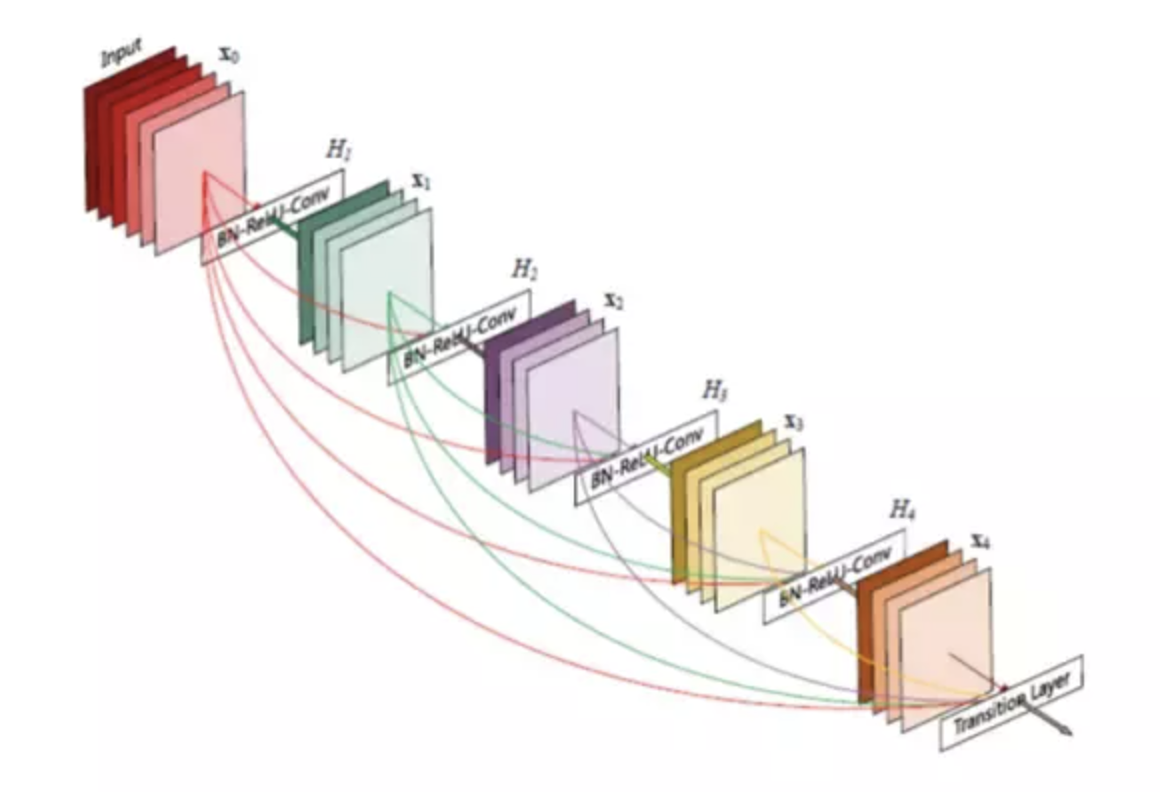

在阅读关于DenseNets的论文后,我发现作者试图通过其层间连接架构来解决梯度消失的问题。下面是那篇论文中的图:

图中表示一个单一的5层密集块(𝐿=5),DenseNet由多个连通的密集块层组成,块层之间有卷积层和池化层。

请注意,在单一的密集块中,当𝑙' >𝑙时,每一层𝑥𝑙直接连接到随后的每一层𝑥𝑙',。因此,每一层𝑙将其特征映射直接传递到剩下的𝐿−𝑙层,而不需要求和/聚合,因此所有层都可以直接访问损失函数的梯度和原始的输入信号。

这一点与ResNet相反,ResNet通过层之间的累加来组合特性。

收藏

理工酷

理工酷

资源下载

资源下载